El archivo robots.txt es fundamental en el mundo del SEO y la gestión de un sitio web, ocupándose de comunicar a los motores de búsqueda que partes del sitio deben ser indexadas y cuáles no. En este artículo vamos a explorar en qué consiste este archivo y por qué debes configurarlo correctamente:

¿Qué es el archivo robots.txt?

Es un archivo de textos simple que se encuentra en el directorio raíz de tu web, como puede ser httpdocs o public_html. El objetivo de dicho archivo es indicarle a los bots de los motores de búsqueda cómo deben rastrear e indexar tu sitio web, incluyendo entre sus funciones:

- Restringir el acceso a ciertas páginas o directorios que no deseas que sean indexados.

- Optimizar el proceso de rastreo evitando que los bots desperdicien su presupuesto de rastreo ("crawl budget") en áreas no importantes.

- Mejorar la privacidad al ocultar contenido que no es relevante para los resultados de búsqueda.

¿Cómo funciona?

Cuando un bot rastrea tu web, lo primero que hace es buscar el archivo robots.txt en el directorio raíz. Si está presente, seguirá las instrucciones indicadas en el archivo, entre las cuales se incluyen:

- User-agent: Especifica a qué bots se aplican las reglas (por ejemplo, Googlebot, Bingbot, etc)

- Disallow: Indica qué URLs o directorios no deben ser rastreados.

- Allow: Permite el rastreo de contenidos en directorios que normalmente está bloqueados.

- Sitemap: Proporciona la ubicación del sitemap XML de tu sitio para facilitar el trabajo de los bots.

Este es un ejemplo de un archivo básico de robots.txt:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: https://tu-sitio-web.com/sitemap.xml

Si no entiendes el contenido de este archivo, a continuación te explicamos que hace cada línea:

- User-agent: *: Aplica las reglas a todos los bots.

- Disallow: /wp-admin/: Bloquea el acceso al directorio /wp-admin/.

- Allow: /wp-admin/admin-ajax.php: Hace una excepción para un archivo específico que los bots pueden rastrear.

- Sitemap: Informa la ubicación del sitemap XML.

¿Dónde encontrar el archivo robots.txt en WordPress?

Por defecto, WordPress genera este archivo de forma virtual, el cual se puede acceder ingresando el dominio de tu sitio web + /robots.txt, como por ejemplo: https://tu-sitio-web.com/robots.txt. Este archivo básico puede ser modificado mediante plugins o agregando un archivo robots.txt físico al directorio raíz de tu servidor.

¿Cómo crear el archivo robots.txt?

Es un proceso muy sencillo crearlo, simplemente debes dirigirte a tu panel del hosting y crear en el directorio raíz de tu web el archivo con ese nombre. Una vez creado y si te manejas bien con las instrucciones que debes indicar en este archivo, las agregas y cuando esté listo lo guardas. Con eso bastará para que tu archivo robots.txt esté funcionando, pero a continuación te explicamos cómo puedes comprobar su funcionamiento.

¿Cómo probar el archivo y subirlo a Google Search Console?

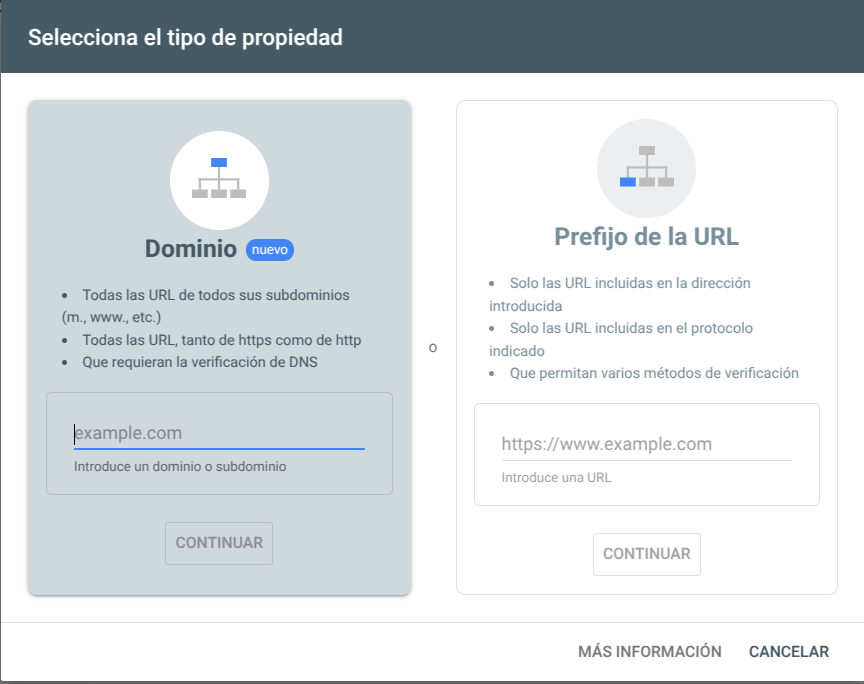

Para verificar si tu robots.txt está funcionando correctamente puede sutilizar Google Search Console, una herramienta que permite a los propietarios de sitios web monitorizar, gestionar y mejorar la presencia de su sitio en los resultados de búsqueda de Google.

Lo primero que debes hacer es verificar tu dominio en Google Search Console a través de alguno de los métodos que ofrece, como agregar un registro DNS o subir un archivo HTML.

Una vez estés verificado, debes dirigirte a Ajustes > robots.txt > Abrir informe, en dónde te mostrará el archivo que obtuvo:

Utilizar plugins en WordPress

Otro método para crear y gestionar tu robots.txt es a través de los plugins que ofrece WordPress, los cuales facilitan la gestión y el uso de este archivo.

Yoast SEO

Uno de los mejores plugins para SEO y que nos permite gestionar el archivo robots.txt:

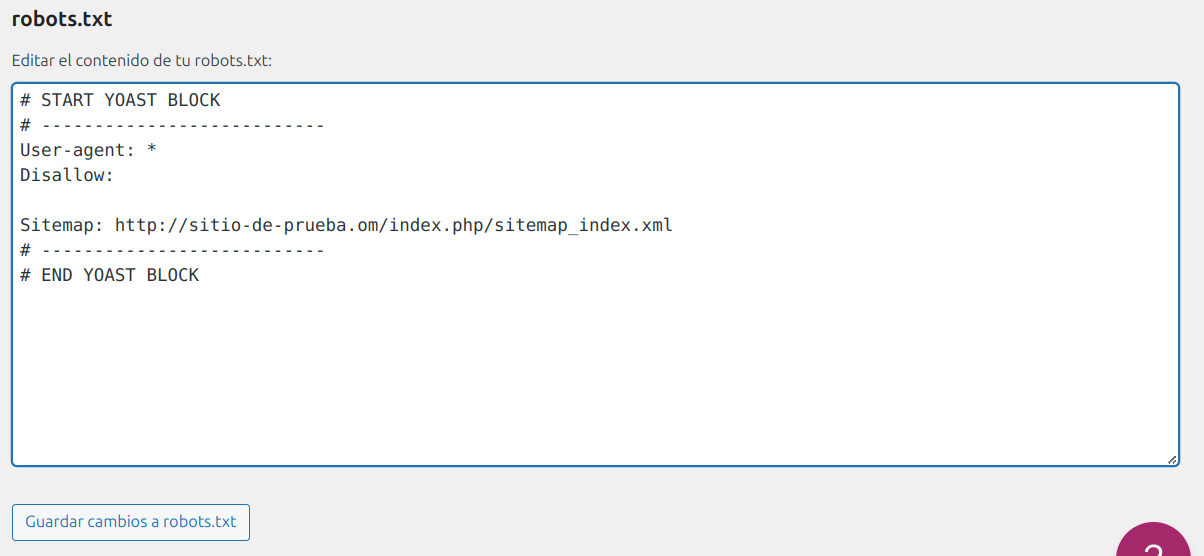

Debemos dirigirnos a Herramientas dentro del plugin y buscamos la opción de Editor de archivos, que nos permitirá editar el archivo en cuestión. Primero deberemos crearlo con el botón que nos indica y luego sí nos dejará editar el archivo que nos generó:

El plugin de Yoast SEO establece sus propias reglas por defecto, las cuales anulan las de tu archivo robots.txt existente. Recuerda de darle al botón de Guardar cambios en robots.txt antes de cerrar tu pestaña tras haber realizado algún cambio.

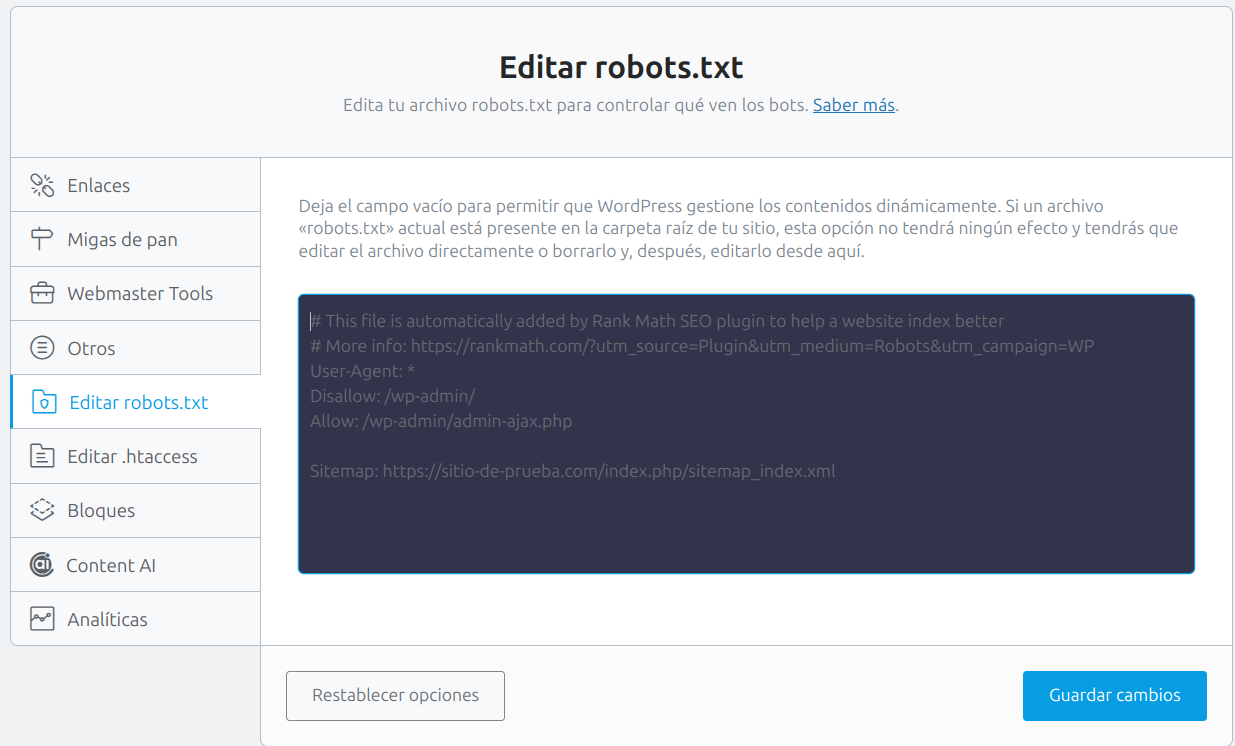

Rank Math SEO

Es una excelente alternativa a Yoast SEO, el cual tambié ofrece una interfaz intuitiva para gestionar el archivo robots.txt:

Antes que nada deberemos asegurarnos estar en el Modo avanzado para poder edtiar el archivo:

Nos dirigimos a Ajustes generales dentro del plugin y entramos a la sección de Editar robots.txt, dónde nos brindará un editor de texto para realizar las modificaciones que deseemos:

Buenas prácticas

El mal uso del archivo robots.txt puede llevar a problemas como la desindexación de contenido importante o una pobre optimización SEO. Te aconsejamos tener en cuenta estas buenas prácticas:

- Evita bloquear recursos esenciales: No bloquees el acceso a archivos CSS, JavaScript o imágenes necesarios para la visualización adecuada de tu sitio.

- Informa siempre tu sitemap: Incluir la ubicación de tu sitemap facilita a los bots la tarea de encontrar y entender la estructura de tu sitio.

- Revisa los logs de rastreo: Utiliza herramientas como Google Search Console para verificar qué páginas están siendo rastreadas y ajusta el archivo robots.txt según sea necesario.

- Bloquea áreas sensibles: Restringe directorios como /wp-includes/, /wp-content/plugins/, y otras rutas que no deben ser visibles públicamente.

- Prueba antes de implementar: Antes de subir un archivo robots.txt nuevo, utiliza herramientas como el probador de robots.txt de Google para asegurarte de que está configurado correctamente.

Problemas comunes al usar el archivo robots.txt

- Desindexación accidental: Si bloqueas contenido importante sin darte cuenta, podrías perder tráfico orgánico.

- Demasiados bloqueos generales: Bloquear rutas como /wp-content/ puede impedir que los bots accedan a imágenes o recursos necesarios.

- No incluir un sitemap: Esto dificulta la navegación eficiente del bot en tu sitio, afectando negativamente el SEO.

- Duplicidad de archivos robots.txt: Tener tanto un archivo virtual como uno físico puede causar conflictos, debes asegurarte de que solo uno esté en uso.